Esta página fue traducida automáticamente.

Complete una encuesta de 1 minuto sobre la calidad de esta traducción.

Cámara monofotónica permite reproducir vídeos en todas las escala de tiempo

Captura de datos ilumina nuevas aplicaciones de visión artificial

Investigadores de procesamiento de imágenes computacionales de la Universidad de Toronto capturan una señal extraña con una cámara especial. Mientras realizaban experimentos de laboratorio con una cámara equipada con un diodo de avalancha de fotones individuales (SPAD), el Toronto Computational Imaging Group detectó una fluctuación inexplicable de 80 kilohercios (kHz).

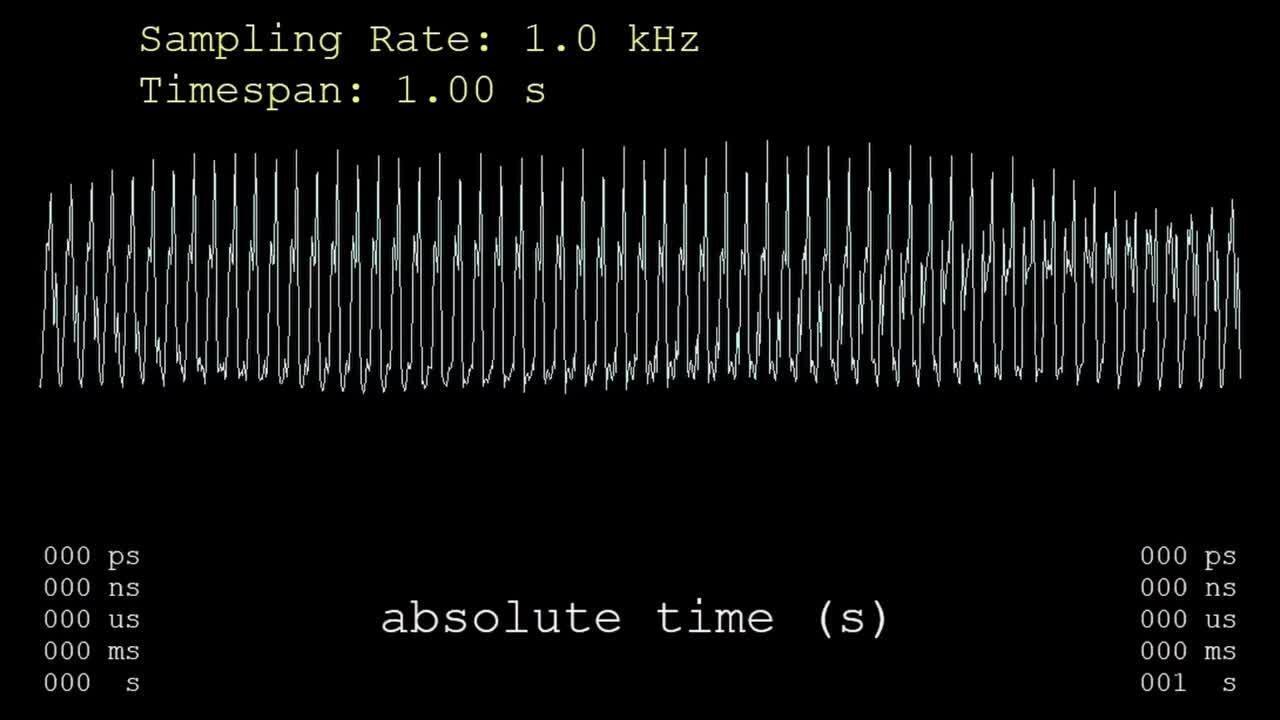

Utilizando el poderoso sensor de imágenes de funcionamiento libre, detectaron cada fotón individual a medida que llegaba desde varias fuentes de luz y registraron su tiempo de llegada preciso, hasta una billonésima de segundo. Después de adquirir todos los datos de cada píxel, el equipo aplicó un algoritmo para crear vídeos que reconstruían la luz en un momento dado en un rango extremo, desde segundos hasta picosegundos.

"Se puede hacer zoom en cualquier escala de tiempo y reproducir un vídeo: 30 cuadros por segundo, mil, un millón, mil millones", dijo el profesor de ciencias de la computación de la Universidad de Toronto, Kyros Kutulakos. "No es necesario saber de antemano la escala de tiempo en la que se desea observar un fenómeno".

Antes de esto, los investigadores podían capturar la luz que se propagaba a través de una escena durante unos pocos nanosegundos, pero no podían obtener imágenes simultáneas de eventos increíblemente rápidos y lentos.

Las tecnologías existentes están especializadas en regímenes de tiempo particulares, explicó el colega de Kutulakos, el profesor adjunto David Lindell. Las cámaras convencionales de alta velocidad pueden alcanzar velocidades de hasta 1 millón de fotogramas por segundo (lo suficientemente rápido para capturar una bala a toda velocidad), pero pasar a miles de millones o billones de fotogramas por segundo requiere cámaras muy especializadas que no pueden capturar eventos que duren más de un microsegundo.

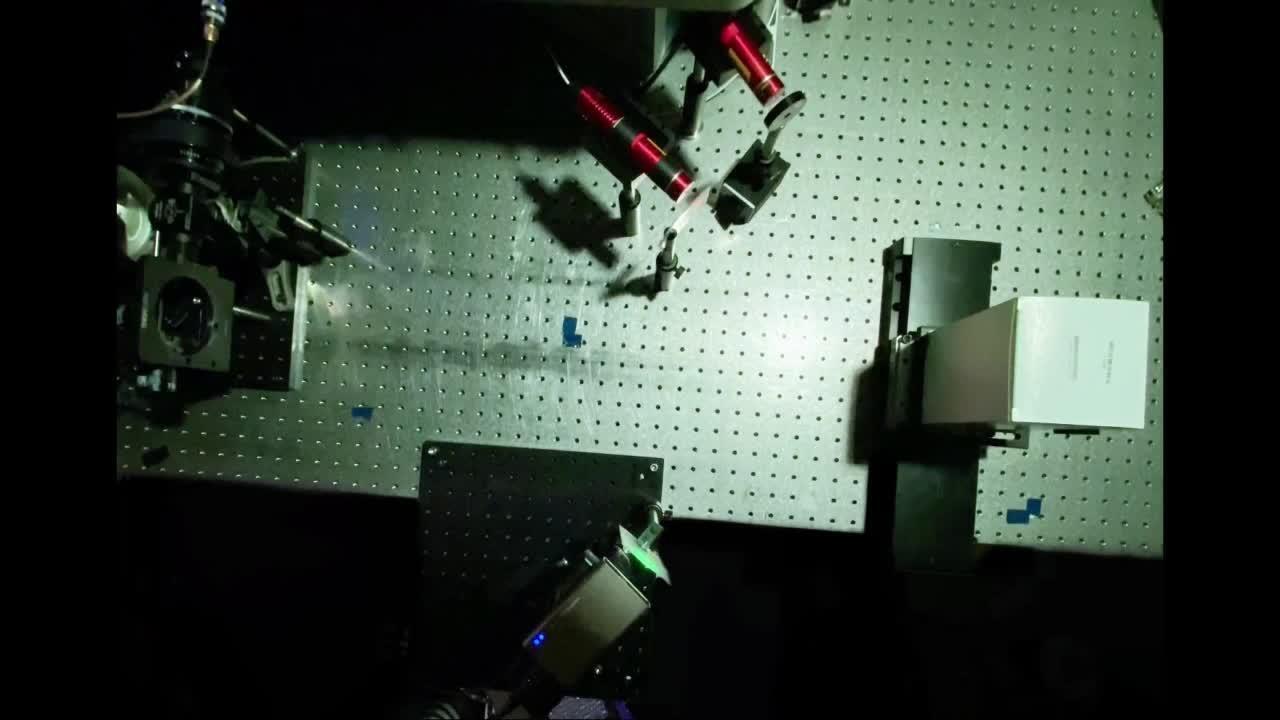

Con un sensor de imágenes de funcionamiento libre, se detecta cada fotón individual de varias fuentes de luz y se registra el tiempo de llegada preciso. (Crédito del vídeo: Universidad de Toronto)

El equipo de la Universidad de Toronto utilizó MATLAB® para adquirir los datos de las marcas de tiempo de los fotones individuales y controlar los componentes móviles en sus configuraciones para su técnica de obtención de imágenes, que el grupo denominó "microscopio del tiempo".

El SPAD de un solo píxel tiene un cabezal de detección de 60 por 60 milímetros con un pequeño sensor en el medio. Cuando el SPAD detectó una extraña señal de 80 kHz, al principio los investigadores se preguntaron si habían encontrado un artefacto. Luego de una inspección detallada, el equipo descubrió el motivo.

"Tenemos LED T8 para bombillas fluorescentes de repuesto en el laboratorio. "Y tienen una fluctuación de 80 kilohercios", dijo Kutulakos. "Ni teníamos idea".

En la reciente Conferencia Internacional sobre Visión artificial (ICCV) en París, el artículo del equipo sobre imágenes pasivas de un solo fotón de banda ultra ancha recibió un prestigioso premio otorgado sólo a dos artículos entre miles presentados por expertos en visión artificial de todo el mundo.

Las posibles aplicaciones de su técnica incluyen nuevos tipos de sistemas de imágenes 3D y LiDAR, así como imágenes científicas, por ejemplo, para capturar eventos biológicos en múltiples escalas de tiempo o para la observación astronómica de breves pulsos de luz que coinciden con ráfagas de radio rápidas.

Miles de millones de fotogramas por segundo

Los seres humanos ven la luz como una experiencia continua: Podemos imaginarnos usando una cámara rápida para capturar imágenes en cámara lenta. Si tenemos cámaras cada vez más rápidas, tal vez podamos seguir disminuyendo la velocidad de reproducción continuamente.

"Pero en algún momento, se produce un cambio", dijo Lindell. "La luz no es continua; es discreta. Y la forma en que capturamos la luz es un fotón a la vez".

"Hemos estado trabajando con sensores de fotón único durante varios años y el proceso de captura con MATLAB todavía funciona bien. Es completamente confiable."

Los diodos de avalancha de fotón único recién comenzaron a estar disponibles de forma más amplia en el mercado durante la última década. El alto coste del dispositivo significaba que muy pocos laboratorios de informática y visión artificial tenían acceso a él, señaló Kutulakos. Los recientes avances en sensores impulsaron al equipo de la Universidad de Toronto a plantear nuevas preguntas sobre problemas que los científicos de otros campos han estado abordando durante décadas.

Los astrónomos especializados en astronomía de rayos gamma, por ejemplo, desplegaron detectores para captar partículas individuales y marcarles el tiempo. Pero estos astrónomos estaban más interesados en la iluminación periódica de estrellas variables que en la función exacta variable en el tiempo que describe el brillo de las estrellas, ya que requiere la física, explicó Kutulakos.

En el laboratorio de Toronto Computational Imaging Group, el posdoctorado Sotiris Nousias y el estudiante de doctorado Mian Wei utilizaron por primera vez un SPAD para capturar información de tiempo de fotones de diodos emisores de luz.

"Los LED tenían una fluctuación y observamos el flujo de salida", dijo Nousias. "Observamos que la corriente en realidad tenía el mismo patrón que la fluctuación y tratamos de encontrar la conexión matemática. Esa fue nuestra inspiración para el proyecto".

Nousias y Wei, primeros autores del artículo de ICCV, se preguntaron qué información podrían obtener si tuvieran acceso a todos los fotones. Los científicos tienden a operar los SPAD de formas sincronizadas especiales. En lugar de ello, el equipo utilizó el sensor en modo asincrónico. A partir de ahí, los investigadores buscaron conectar las llegadas de fotones discretos con una función continua subyacente que describe la intensidad de la luz que varía en el tiempo.

"Estamos recolectando fotones pasivamente y tratando de reconstruir la contribución de todas las fuentes de luz en el entorno, ya sea que la variación en la intensidad sea rápida o lenta", dijo Kutulakos.

En una configuración experimental, el equipo capturó diferentes luces simultáneamente y las reprodujo a diferentes velocidades. El SPAD observó un único punto en una superficie blanca. Luz de un láser pulsado estroboscópico de 3 megahercios, láser pulsado estroboscópico de 40 megahercios y proyector láser de escaneo de trama pasó a través de un difusor e incidió en el punto blanco. Una bombilla inteligente brillaba en lo alto.

Extrajeron un flujo de información temporal de la cámara que indicaba cuándo un fotón impactaba el sensor y extrajeron información de intensidad. El equipo utilizó MATLAB para dirigir el haz y obtener una imagen, garantizar la alineación de los píxeles a tiempo y automatizar toda la adquisición de datos.

"Hemos trabajando con sensores de fotones individuales durante varios años y el proceso de captura de MATLAB todavía funciona bien", dijo Lindell. "Es completamente confiable."

En concreto, usaron Image Processing Toolbox™, Computer Vision Toolbox™, Signal Processing Toolbox™, Data Acquisition Toolbox™ y Parallel Computing Toolbox™ en el proyecto. Nousias agregó que también crearon una interfaz gráfica personalizada para controlar los espejos de escaneo en algunos de los experimentos.

Los SPAD modernos pueden generar imágenes computacionales mucho más complejas de lo que los investigadores imaginaban anteriormente.

"Nunca pensamos que podríamos ver la fluctuación de los pulsos de láser asincrónicamente en el entorno", dijo Kutulakos.

Configuración experimental que captura múltiples fuentes de luz en un solo punto sobre una superficie blanca. (Crédito del vídeo: Universidad de Toronto)

A toda velocidad por el tiempo

La reconstrucción del equipo permitió enfocarse en tasas de muestreo de un segundo, desde el fluctuación del proyector láser, hasta llegar a casi nueve órdenes de magnitud, a un pulso individual en la escala de nanosegundos del láser de 3 megahercios. Su método también permitió recrear un vídeo reproducido en un proyector de televisión láser que no estaba en la línea de visión. En este caso, se trataba del león en blanco y negro de la Metro Goldwyn Mayer recreado únicamente a partir de la señal de escaneo rasterizado.

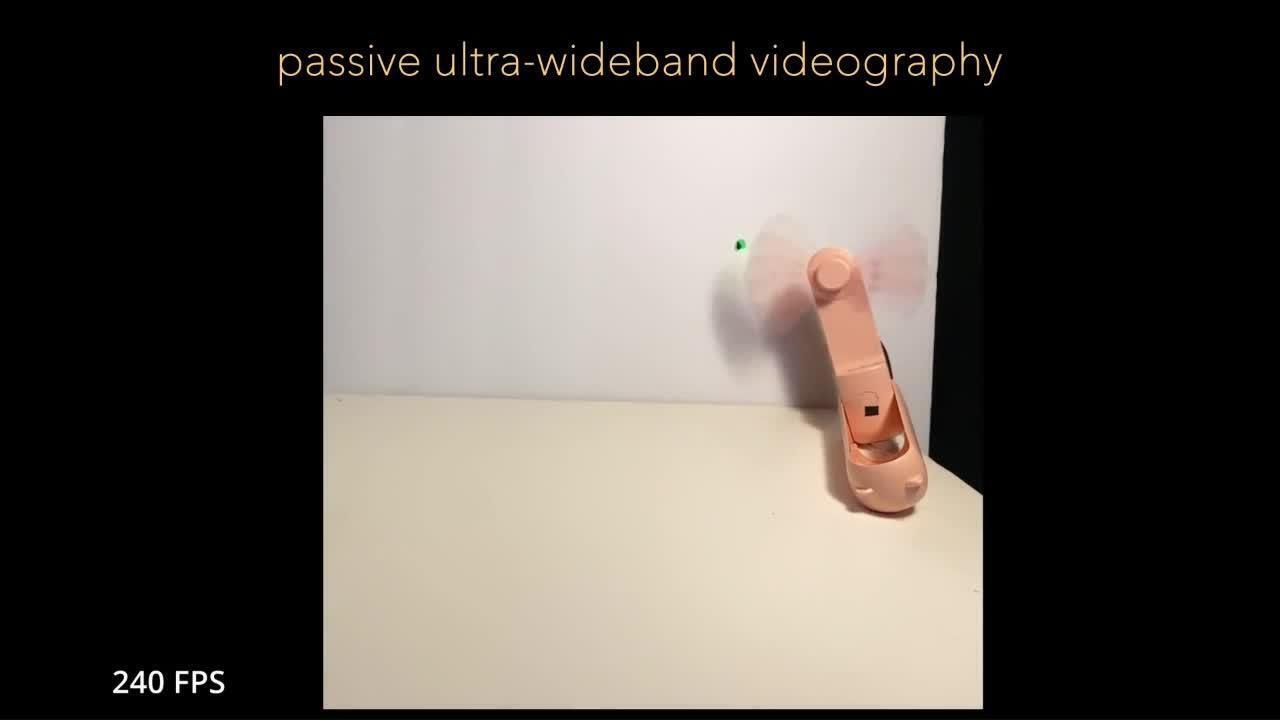

Otra configuración incluía un ventilador portátil de color rosa que funcionaba con pilas sobre un fondo blanco. Para demostrar la videografía pasiva de banda ultra ancha, iluminaron el ventilador giratorio con pulsos láser. A diferencia de las técnicas de imágenes activas que producen un efecto borroso, su técnica congela claramente las aspas del ventilador moviéndose en una escala de tiempo diferente a la de la luz estroboscópica. La escena aún permanece visible cerca de la escala de gigahercios, mientras un frente de onda rojo barre las aspas de un ventilador aparentemente congeladas.

"Cuando adquieres un equipo nuevo, si no tienes el soporte necesario para realizar la interfaz, entonces tienes que aprovechar diferentes GUI para obtener los datos que deseas. "MATLAB nos proporcionó una forma conveniente de controlar todos los componentes para realizar la captura de datos".

"Es como una cámara de vídeo muy rápida", dijo Nousias. "Con una cámara móvil, tomas una instantánea. Pero en nuestro caso, tomamos una instantánea de una instantánea de una instantánea. "Estamos viajando rápidamente a través del tiempo".

El equipo ya estaba familiarizado con MATLAB cuando comenzaron a utilizar equipos de imágenes para el proyecto hace ocho años. "Todas las herramientas son muy fáciles de integrar y nos proporcionan un acceso rápido a los datos", afirmó Nousias. "Si algo sale mal y tenemos que recuperar los datos, es fácil de visualizarlo y nos ahorra tiempo".

Wei también agradeció el soporte de MATLAB . "Cuando adquieres un equipo nuevo, si no tienes el soporte necesario para hacer la interfaz, entonces tienes que aprovechar diferentes GUI para obtener los datos que quieres", dijo. "MATLAB nos proporcionó una forma conveniente de controlar todos los componentes para realizar la captura de datos".

Lindell estuvo de acuerdo. "El equipo que utilizamos es bastante heterogéneo. "Construimos una única interfaz de programación a partir de bibliotecas existentes", dijo. "Si no tuviéramos MATLAB, tendríamos que lidiar con diferentes bibliotecas de terceros o extensiones que la gente intentaba construir en otros lenguajes de programación".

La videografía pasiva de banda ultra ancha congela las aspas del ventilador moviéndose en una escala de tiempo diferente de la luz estroboscópica. Las aspas permanecen visibles cerca de la escala de gigahercios mientras un frente de onda rojo barre las aspas del ventilador aparentemente congeladas. (Crédito del vídeo: University of Toronto

Wei estimó que, sin acceso al software informático técnico, la integración de cada nuevo componente podría llevar días o semanas. "Verificar dos veces que los componentes funcionaron como estaba previsto agregaría aún más tiempo", dijo.

"Con nuestras configuraciones pudimos trasladar al nuevo equipo de Windows® el código que se había estado ejecutando antes", continuó Wei. "Ahora otra persona puede utilizar código y ejecutar el sistema también".

Posibilidades de imágenes dinámicas

Recibir un premio al mejor artículo en la Conferencia Internacional sobre Visión artificial representó un importante logro profesional para los investigadores del Toronto Computational Imaging Group. Los organizadores de la conferencia seleccionaron sólo dos artículos entre 8.068 presentados, dijo Lindell.

"En una época en la que el aprendizaje profundo domina la conversación, este fue un buen recordatorio de que todavía se necesitan investigaciones que nos ayuden a comprender los fenómenos físicos básicos y cómo podemos detectar estos fenómenos utilizando tecnologías emergentes", dijo.

"Creo que habrá resultados que no podemos anticipar cuando apuntemos la cámara al laboratorio o incluso al exterior. No veo la hora. Será una nueva forma de capturar el mundo".

Los investigadores esperan que su descubrimiento inspire nuevos avances. Un área propicia para la exploración es el LiDAR flash, una técnica que produce una imagen de profundidad de alta resolución a partir de un láser pulsado difuso en lugar de un láser pulsado de escaneo. Normalmente, esto implica enviar luz a la escena, medir cuánto tiempo tarda en regresar y usar esta información de tiempo para medir la distancia.

"Uno de los aspectos a tener en cuenta es que es necesario sincronizar la fuente de luz con el sistema para que este mecanismo funcione", explicó Wei. "Dada nuestra capacidad de medir señales de forma asincrónica, nos interesa comprender si podríamos utilizar una fuente de luz asincrónica para realizar un LiDAR con flash".

En biología, eventos como el plegamiento o la unión de proteínas pueden ocurrir en escalas de tiempo que van desde nanosegundos hasta milisegundos. Lindell añadió que el equipo ha estado discutiendo sus técnicas de imágenes con expertos en biología de la universidad.

"El hecho de que estos eventos estén sucediendo en estas escalas de tiempo es interesante para nosotros, y la posibilidad de observarlos de una manera que la gente no ha podido hasta ahora es interesante", dijo.

El reenfoque computacional podría tener aplicaciones en otras ciencias. Los astrofísicos han querido comprender qué causa ráfagas de radio rápidas (FRB) desde que un radiotelescopio detectó el fenómeno por primera vez hace 20 años. Estas misteriosas explosiones de energía ocurren en el cielo y solo duran milisegundos, pero cada una es increíblemente poderosa. El reenfoque computacional podría permitir la detección de FRB en el dominio óptico.

"No sabemos cuándo ocurrirán", dijo Nousias. "Es necesario monitorear el cielo y regresar a los datos en la escala de tiempo de nanosegundos para observarlos. Ahora tenemos la herramienta para hacerlo".

Kutulakos anticipa que su método SPAD podría ayudar a detectar problemas o defectos en componentes mecánicos diseñados que las inspecciones estándar no detectan. Cuando un motor tiene problemas, las vibraciones pueden indicar un problema, pero el motivo exacto puede resultar difícil de determinar sin más información. Apuntar una cámara al motor y recopilar todos los datos, puede solucionarlo, dijo.

El grupo también está colaborando con otros investigadores en microelectrónica para ampliar lo que pueden hacer las cámaras. Una cámara de un solo píxel permite al equipo producir vídeos de movimientos repetitivos, como las aspas de un ventilador girando, pero los eventos verdaderamente dinámicos requieren un sensor 2D.

El equipo planea trabajar en mejorar su técnica. La reconstrucción de las señales sigue siendo un proceso que consume bastante tiempo y es computacionalmente ineficiente, señaló Lindell. Están trabajando en capturar eventos en todas las escalas de tiempo en tiempo real.

"Creo que habrá resultados que no podemos anticipar cuando apuntemos la cámara al laboratorio o incluso al exterior", dijo Lindell. "No veo la hora. Será una nueva forma de capturar el mundo".

Más casos prácticos

IA

Aceleración del descubrimiento científico con microscopía impulsada por IA

Procesamiento de imágenes fácil de usar y conocimientos a partir de conjuntos de datos masivos de hojas de luz

PROCESAMIENTO DE IMÁGENES

Desarrollo de una cámara subacuática en 3D con captura de imágenes con selección de rango

PROCESAMIENTO DE IMÁGENES

Exploración del ecosistema más grande del mundo: 500 metros bajo la superficie del océano

Nat Geo desarrolla una cámara robótica submarina para explorar las profundidades